Introducción

Las Redes de Neuronas o Redes Neuronales, son

un paradigma de aprendizaje y procesamiento automático, inspirado en la forma

en que funciona el sistema nervioso de los animales. Se trata de un sistema de

interconexiones de neuronas que colaboran entre sí para producir una salida.

Las Redes de Neuronas o Redes Neuronales, son

un paradigma de aprendizaje y procesamiento automático, inspirado en la forma

en que funciona el sistema nervioso de los animales. Se trata de un sistema de

interconexiones de neuronas que colaboran entre sí para producir una salida.

Ya que hoy en

día la IA pretende imitar la

Inteligencia natural, ya que las redes

neuronales pretenden imitar arquitectura cerebral( neuronas + conexiones) ya que

sabemos que dan inteligencia. Cabe recordar

que el termino inteligencia es bastante

antiguo, pero en este caso n el que hablamos

de redes neuronales, lo consideramos inteligencia a aquellas personas que

sabiendo de un cierto tema, son capaces

de dar una respuesta a un problema dado

como por ejemplo cálculos clasificación,

etc.

MARCO TEORICO

EL PERCEPTRÓN

La

red tipo Perceptrón fue inventada por el psicólogo Frank Rosenblatt en el año

1957. Su intención era ilustrar algunas propiedades fundamentales de los

sistemas inteligentes en general, sin entrar en mayores detalles con respecto a

condiciones específicas y desconocidas para organismos biológicos concretos.

Rosenblatt creía que la conectividad existente en las redes biológicas tiene un

elevado porcentaje de aleatoriedad, por lo que se oponía al análisis de

McCulloch Pitts en el cual se empleaba lógica simbólica para analizar

estructuras bastante idealizadas. Rosenblatt opinaba que la herramienta de

análisis más apropiada era la teoría de probabilidades, y esto lo llevó a una

teoría de separabilidad estadística que utilizaba para caracterizar las

propiedades más visibles de estas redes de interconexión ligeramente aleatorias.

El primer modelo de Perceptrón fue desarrollado en un ambiente biológico

imitando el funcionamiento del ojo humano, el fotoperceptrón como se le llamo

era un dispositivo que respondía a señales ópticas; la luz incide en los puntos

sensibles (S) de la estructura de la retina, cada punto S responde en forma

todo-nada a la luz entrante, los impulsos generados por los puntos S se

transmiten a las unidades de asociación (A) de la capa de asociación; cada

unidad A está conectada a un conjunto aleatorio de puntos S, denominados

conjunto fuente de la unidad A, y las conexiones pueden ser tanto excitatorias

como inhibitorias. Las conexiones tienen los valores posibles +1, -1 y 0,

cuando aparece un conjunto de estímulos en la retina, una unidad A se activa si

la suma de sus entradas sobrepasa algún valor umbral; si la unidad esta

activada, A produce una salida que se envía a la siguiente capa de unidades.

La

red tipo Perceptrón fue inventada por el psicólogo Frank Rosenblatt en el año

1957. Su intención era ilustrar algunas propiedades fundamentales de los

sistemas inteligentes en general, sin entrar en mayores detalles con respecto a

condiciones específicas y desconocidas para organismos biológicos concretos.

Rosenblatt creía que la conectividad existente en las redes biológicas tiene un

elevado porcentaje de aleatoriedad, por lo que se oponía al análisis de

McCulloch Pitts en el cual se empleaba lógica simbólica para analizar

estructuras bastante idealizadas. Rosenblatt opinaba que la herramienta de

análisis más apropiada era la teoría de probabilidades, y esto lo llevó a una

teoría de separabilidad estadística que utilizaba para caracterizar las

propiedades más visibles de estas redes de interconexión ligeramente aleatorias.

El primer modelo de Perceptrón fue desarrollado en un ambiente biológico

imitando el funcionamiento del ojo humano, el fotoperceptrón como se le llamo

era un dispositivo que respondía a señales ópticas; la luz incide en los puntos

sensibles (S) de la estructura de la retina, cada punto S responde en forma

todo-nada a la luz entrante, los impulsos generados por los puntos S se

transmiten a las unidades de asociación (A) de la capa de asociación; cada

unidad A está conectada a un conjunto aleatorio de puntos S, denominados

conjunto fuente de la unidad A, y las conexiones pueden ser tanto excitatorias

como inhibitorias. Las conexiones tienen los valores posibles +1, -1 y 0,

cuando aparece un conjunto de estímulos en la retina, una unidad A se activa si

la suma de sus entradas sobrepasa algún valor umbral; si la unidad esta

activada, A produce una salida que se envía a la siguiente capa de unidades.

CARACTERÍTICAS PRINCIPALES DEL PERCEPTRON SIMPLE

- Fue introducido por Frank Rosenblatt.

- Sistema capaz de realizar tareas de clasificación de forma automática.

- A partir de un número de ejemplos etiquetados, el sistema determina la

ecuación del plano discriminante.

- Puede usarse como neurona dentro de otro tipo de red de neurona

artificial.

- Aprendizaje supervisado y conexiones en un sólo sentido.

- Es reconocido por su capacidad de aprender a reconocer patrones

- Es un modelo unidireccional compuesto por dos capas de neuronas.

- Con respecto al entrenamiento las neuronas de entrada son discretas y

la función de activación de las de salida es de tipo escalón.

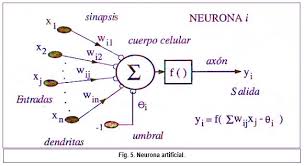

ARQUITECTURA

Es una red monocapa con

varias neuronas de entrada conectadas a la neurona de salida. Observando la

imagen anterior podemos calcular el valor de la salida, del siguiente modo:

- En el caso de

que la salida sea +1, la entrada pertencerá a una clase, situada a un lado

del hiperplano

- En el caso de

que la salida sea -1, la entrada pertencerá a la clase contraria, situada

al otro lado del hiperplano

El perceptron simple es

un hiperplano de dimensión n-1 capaz de separar las clases. La ecuación de

dicho interplano es:

w1x1+w2x2+θ=0

La cual si se simplifica

queda del siguiente modo:

Donde la parte que

multiplica x1 es la

pendiente de la recta y la otra parte es el punto de corte con el eje de

ordenadas.

APRENDIZAJE SUPERVISADO

Para el proceso de

aprendizaje del Perceptron Simple es necesario saber:

- Los datos

son puntos en un espacio multidimensional.

- Se dispone

de un conjunto de observaciones, puntos representados en el hiperplano, de

los que se sabe su categoría o clase.

- Se tiene

que determinar la ecuación del hiperplano que separa los ejemplos de un

tipo de los de otro.

- La

ecuación del hiperplano se deduce a partir de los ejemplos.

- El

aprendizaje es proceso iterativo supervisado.

- Hasta

encontrar el hiperplano discriminante se debe ir modificando los

parametros de la red (pesos y umbral).

- Este

proceso de aprendizaje supervisado tiene un número finito de iteracciones.

Los pasos a seguir para

el aprendizaje son:

- Inicialización

aleatoria de los pesos y umbral.

- Se toma un

patrón de entrada-salida.

- Se calcula

la salida de la red.

- Si y =

d(x) (clasificación correcta).

Si y ≠ d(x) (clasificación incorrecta) se modifican los parámetros. - Se vuelve

al paso 2 hasta completar el conjunto de patrones de entrenamiento.

- Se repiten

los pasos anteriores hasta alcanzar el criterio de parada.

PERCEPTRON

MULTICAPA

HISTORIA

En 1969, Minsky y

Papert, demuestran que el perceptron simple y ADALINE no puede resolver

problemas no lineales (por ejemplo, XOR). La combinación de varios perceptrones

simples podría resolver ciertos problemas no lineales pero no existía un

mecanismo automático para adapatar los pesos de la capa oculta. Rumelhart y

otro autores, en 1986, presentan la "Regla Delta Generalizada" para

adaptar los pesos propagando los errores hacia atrás, es decir, propagar los

erroes hacia las capas ocultas inferiores. De esta forma se consigue trabajar

con multiples capas y con funciones de activación no lineales. Se demuestra que

el perceptron multicapa es un aproximador universal. Un perceptron multicapa

puede aproximar relaciones no lineales entre los datos de entrada y salida.

Esta red se ha convertido en una de las arquitecturas más utilizadas en el

momento.

ARQUITECTURA

Este modelo se

compone de:

- Capa de entrada: sólo

se encarga de recibir las señales de entrada y propagarla a la siguiente capa.

- Capa de salida:

proporciona al exterior la respuesta de la red para cada patrón de entrada.

- Capas ocultas:

realizan un procesamiento no lineal de los datos de entrada.

La propagación de los

patrones de entrada en el perceptron multicapa define una relación entre las

variables de entrada y variables de salida de la red. Esta relación se obtiene

propagando hacia delante los valores de entrada. Cada neurona de la red procesa

la información recibida por sus entradas y produce una respuesta o activación

que se propaga, a través de las conexiones correspondientes, a las neuronas de

la siguiente capa.

CARACTERÍSTICAS

DEL PERCEPTRON MULTICAPA.

- Es una de las

arquitecturas más utilizadas para resolver problemas reales.

- Se evalua un conjunto

de datos de entradas y se obtienen valores reales o vectores con valores

reales.

- Se diferencia del

perceptron simple y ADALINE en que tiene una capa oculta.

- Todas las neuronas se

relacionan con todas las neuroas, incluyendo las neuronas de la capa oculta.

APRENDIZAJE EN EL PERCEPTRON MULTICAPA

1. Se inicializan los

pesos y umbrales (valores aleatorios próximos a 0).

2. Se presenta un patrón

"n" de entrenamiento y se propaga hacia la salida, obteniendo la

salida de la red "y(n)"

3. Se evalúa el error

cuadrático, "e(n)", cometido por la red para cada patrón.

4. Se aplica la Regla

Delta Generalizada para modificar pesos y umbrales:

·

Se calculan los valores

"δ" para todas las neuronas de la capa de salida.

·

Se calcula "δ"

para el resto de neuronas, empezando por la última capa oculta y terminando en

la capa de entrada.

·

Se modifican los pesos y

umbrales.

5. Se repiten los pasos

2, 3 y 4 para todo el patrón de entrenamiento.

6. Se evalúa el error

total de la red.

7. Se repite hasta

alcanzar el error mínimo de entrenamiento, realizando "m" ciclos. Se

pueden establecer otros criterios de parada:

·

El error del entrenamiento

se estabilice.

·

El error de validación se

estabilice.

·

El

error de validación aumente.

CONCLUSIÓN

La Inteligencia Artificial es una rama muy importante ya que estudia

las neuronas de un ser vivo, para

desarrollar neuronales artificiales que actúan similar alas del hombre, también

cabe recalcar que el hombre

va más allá de la perfección

buscando solucionar problemas en el mundo real, atreves de las agentes

que están diseñados con neuronas artificiales, y puedan dar solución a un problema.

BIBLIOGRAFÍA

Javier, R. 2013. El perceptrón (En

linea). Consultado, 13 de enero.2016. Formato PDF. Disponible en: ftp://decsai.ugr.es/pub/usuarios/castro/Actividades/Redes-Neuronales/Apuntes/Apuntes%20Javier%20Rodriguez%20Blazquez/Redes%20de%20una%20capa.pdf

Pedro ,V e Ines , G. 2004.

Redes de neuronas

artificiales un Enfoque Práctico. 2 ed. España. Pearson Education. p 45-50.

No hay comentarios:

Publicar un comentario